Pythonで動かして学ぶ!あたらしい機械学習の教科書

伊藤 真 著

- 形式:

- 書籍

- 発売日:

- 2018年01月24日

- ISBN:

- 9784798144986

- 定価:

- 2,948円(本体2,680円+税10%)

- 仕様:

- A5・400ページ

- カテゴリ:

- 人工知能・機械学習

- キーワード:

- #プログラミング,#開発手法,#データ・データベース,#ビジネスIT

- シリーズ:

- AI & TECHNOLOGY

【本書の概要】

人工知能開発の分野では、機械学習(教師あり学習)を利用した開発が非常に多くなってきています。

本書は学習環境の準備から始まり、Pythonの基本および数学の基本を丁寧に解説。

その上で、教師あり学習について、サンプルを元に解説しています。

初学者でも理解しやすいようにイラストを多く利用しています。

また、教師あり学習だけにとどまらず、教師なし学習についても触れています。

【本書の特徴と構成】

機械学習について基礎からきちんと学習できよう、構成を工夫しています。

第1章では開発環境の準備について解説しています。

第2章では機械学習に必要なPythonの基礎知識について丁寧に解説しています。

第3章では機械学習でよく利用するグラフの描画について主だった方法を中心に解説しています。

第4章では機械学習に必要な数学の知識について解説しています。

第5章では教師あり学習(回帰)についてサンプルを元に丁寧に解説しています。

第6章では教師あり学習(分類)についてサンプルを元に丁寧に解説しています。

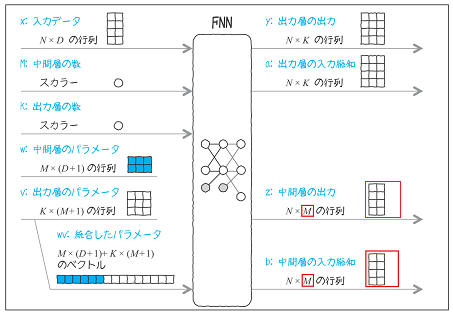

第7章ではニューラルネットワーク・ディープラーニングの基本について解説しています。

第8章ではニューラルネットワーク・ディープラーニングの応用について解説しています。

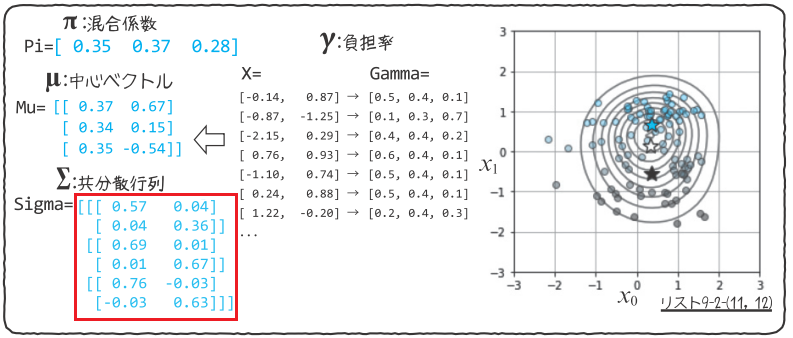

第9章では教師なし学習について、ポイントを押さえて解説しています。

特に第5章から第9章では、機械学習を学ぶ過程でつまづきやすいポイントについて

著者がピックアップし、丁寧に解説しています。

【対象読者】

機械学習について学びたい初学者

【著者】

伊藤真(いとう・まこと)

栃木県出身、神奈川県在住。

2000年、東北大学大学院にてラットのナビゲーション行動の数理モデルの研究で情報科学博士取得。

2004-2016年、沖縄科学技術大学院大学神経計算ユニットの実験グループリーダーを務め、

ラットの脳活動のデータ収集とその解析に従事。

主に、ラットの選択行動と脳活動を強化学習モデルで説明する研究を行ってきた。

2017年より、プログレス・テクノロジーズ株式会社に入社、人工知能の産業利用を目指す。

趣味はダンボール工作。

第2章 Pythonの基本

第3章 グラフの描画

第4章 機械学習に必要な数学の基本

第5章 教師あり学習:回帰

第6章 教師あり学習:分類

第7章 教師あり学習:ニューラルネットワーク・ディープラーニング

第8章 教師あり学習:ニューラルネットワーク・ディープラーニングの応用(手書き数字の認識)

第9章 教師なし学習

お問い合わせ

内容についてのお問い合わせは、正誤表、追加情報をご確認後に、お送りいただくようお願いいたします。

正誤表、追加情報に掲載されていない書籍内容へのお問い合わせや

その他書籍に関するお問い合わせは、書籍のお問い合わせフォームからお送りください。

利用許諾に関するお問い合わせ

本書の書影(表紙画像)をご利用になりたい場合は書影許諾申請フォームから申請をお願いいたします。

書影(表紙画像)以外のご利用については、こちらからお問い合わせください。

-

reshapeの記法

本書のP.143のリストなどで

reshape(xx0,xn*xn,1)

という形で記載しています。

本来の記法にのっとれば

reshape(xx0, xn*xn)

となります。 -

補足情報 P.220 リスト6-1-(5)のコードについて

P.220 リスト6-1-(5) 上から、6行目にある、

------------------------

for n in range(len(y)):

cee = cee - (t[n] * np.log(y[n]) + (1 - t[n]) * np.log(1-t[n])

cee = cee / N_n

------------------------

のコードについて、「以下のように考えることもできるのでは?」というお問い合わせがありました。

------------------------

for n in range(len(y)):

cee = cee + (t[n] * np.log(y[n]) + (1 - t[n]) * np.log(1-t[n])

cee = - cee / N_n

------------------------

なぜそうしなかったのか、その理由を説明します。

上記の2つのコードで計算される値はどちらも変わりませんし、たしかに下のコードのほうが式 6-17 と照らし合わせると、しっくりとくるかもしれません。

筆者が本書で書いた理由は、マイナスをつけた、

- (t[n] * np.log(y[n]) + (1 - t[n]) * np.log(1-t[n])

という量が、1つ1つのデータの交差エントロピー誤差に対応するためです。

このように書くことで、「1つ1つのデータの交差エントロピー誤差を平均したものが、

全体の交差エントロピー誤差になる」という意味を残せると思ったからです。

このような書き方は、P.236 リスト6-2-(9) でもしています。 -

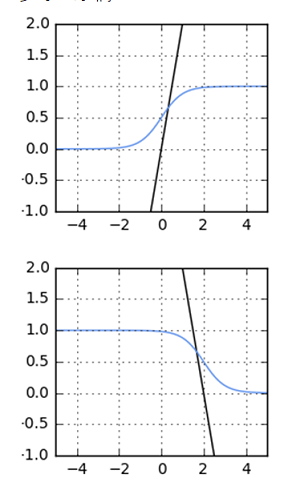

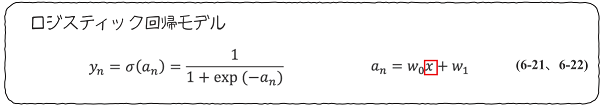

図6.6 ロジスティック回帰モデル 図の下の説明の補足

図6.6 ロジスティック回帰モデル 図の下の説明の補足「シグモイド関数を通した直線は、0と1の範囲につぶされる。直線が0の値をとる点は、その中間の0.5の値となる。」の箇所の補足説明です。

シグモイド関数を通した直線は、0と1の範囲につぶされます。

直線が(縦軸のメモリが)0の値をとる点は、その (シグモイド関数の出力の0と1の範囲の) 中間の0.5の値となります。

例えば図6.6の一番下のグラフでは、直線は、x = 2 の時に縦軸が 0 となっています。この x = 2 のときに、シグモイド関数の出力は0.5 となります。

-

P219 全角フォントについて

下から7行目にある「式 6-16 に-1 を掛けたものを考えます。」の「-1」が全角フォントになっていますが、半角の「-1」となります。

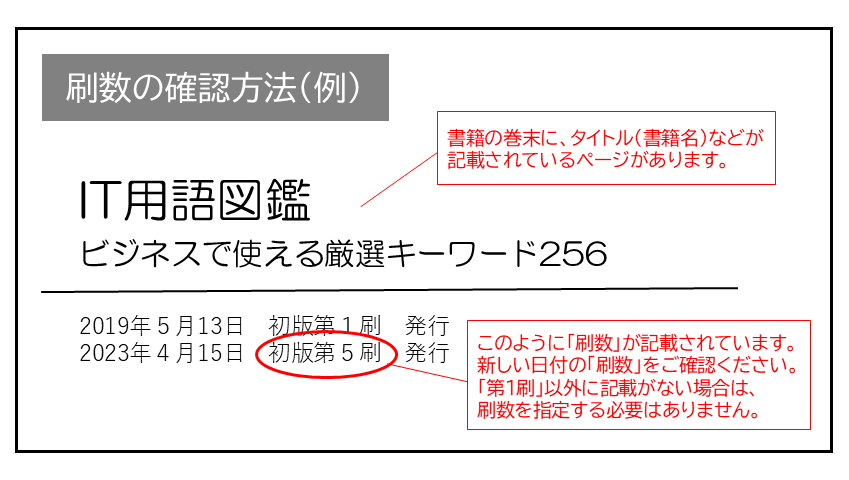

現在表示されている正誤表の対象書籍

書籍の種類:紙書籍

書籍の刷数:全刷

書籍によっては表記が異なる場合がございます

本書に誤りまたは不十分な記述がありました。下記のとおり訂正し、お詫び申し上げます。

対象の書籍は正誤表がありません。

| ページ数 | 内容 | 書籍修正刷 | 電子書籍訂正 | 発生刷 | 登録日 | ||||||

|---|---|---|---|---|---|---|---|---|---|---|---|

| 014 下から2行目 |

|

2刷 | 済 | 1刷 | 2018.02.02 | ||||||

| 036 上から6行目 |

|

2刷 | 済 | 1刷 | 2018.02.02 | ||||||

| 045 下から3行目 |

|

4刷 | 済 | 1刷 | 2018.05.07 | ||||||

| 065 上から4行目 |

|

2刷 | 済 | 1刷 | 2018.02.02 | ||||||

| 089 上から3~4行目 |

|

2刷 | 済 | 1刷 | 2018.02.02 | ||||||

| 093 上から2行目 |

|

2刷 | 済 | 1刷 | 2018.02.02 | ||||||

| 094 上から5行目 |

|

2刷 | 済 | 1刷 | 2018.02.02 | ||||||

| 102 下から7行目 |

|

未 | 未 | 1刷 | 2019.09.04 | ||||||

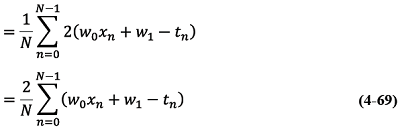

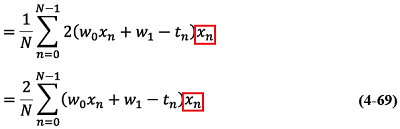

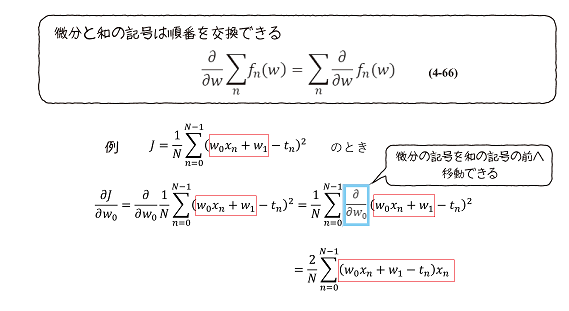

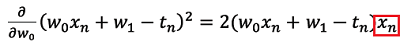

| 102 式4-69、図4.15(図内の数式とキャプション)、上から5行目 |

|

3刷 | 済 | 1刷 | 2018.02.06 | ||||||

| 103 1行目 |

|

3刷 | 済 | 1刷 | 2018.02.06 | ||||||

| 111 1行目 |

|

3刷 | 済 | 1刷 | 2018.02.06 | ||||||

| 120 上から1行目 |

|

2刷 | 済 | 1刷 | 2018.02.02 | ||||||

| 126 図4.30 下の枠内 |

|

2刷 | 済 | 1刷 | 2018.02.02 | ||||||

| 126 下から3行目 |

|

3刷 | 済 | 1刷 | 2018.02.06 | ||||||

| 138 式4-135 、図4.35 |

|

未 | 未 | 1刷 | 2020.01.06 | ||||||

| 141 式4-143 |

|

2刷 | 済 | 1刷 | 2018.01.30 | ||||||

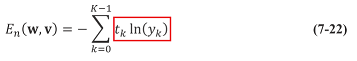

| 153 図5.5 の下の吹き出し |

|

5刷 | 済 | 1刷 | 2018.07.06 | ||||||

| 158 リスト 5-1-(10) 12行目は不要 |

|

3刷 | 済 | 1刷 | 2018.02.27 | ||||||

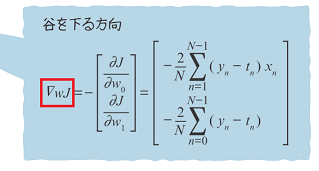

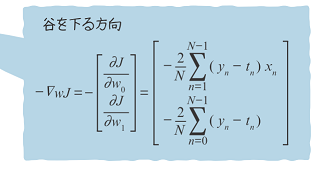

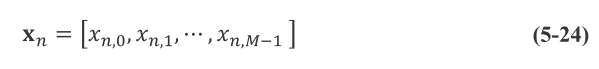

| 166 下から6行目の文章、式5-23、式5-24 |

|

未 | 未 | 1刷 | 2020.01.31 | ||||||

| 167 下から2行目 |

|

2刷 | 済 | 1刷 | 2018.02.27 | ||||||

| 167 本文上から6行目、式5.26、本文下から1行目 |

|

未 | 未 | 1刷 | 2020.01.31 | ||||||

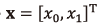

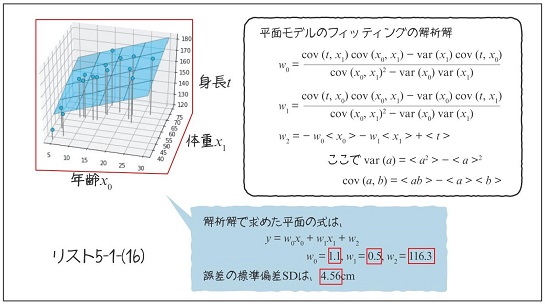

| 171 リスト5-1-(16)、上から9から10行目のw0 とw1 の内容が逆、及び本文下から2行目 |

|

3刷 | 済 | 1刷 | 2018.02.07 | ||||||

| 172 図5.11、グラフの修正、吹き出しの中の文字の修正 |

|

3刷 | 済 | 1刷 | 2018.02.07 | ||||||

| 174 上から4行目 |

|

4刷 | 済 | 1刷 | 2018.04.26 | ||||||

| 174 上から6行目 |

|

2刷 | 済 | 1刷 | 2018.02.02 | ||||||

| 176 式(5-50)の右辺行列の上から2段目、左端の列、(2行D列の要素) |

|

未 | 未 | 1刷 | 2020.02.14 | ||||||

| 186 図5.14内 解析解 φの行列の左下の要素 |

|

5刷 | 済 | 1刷 | 2018.07.12 | ||||||

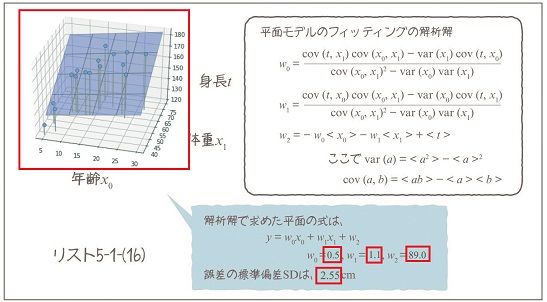

| 189 リスト5-2-(10)上から3~6行目 |

|

4刷 | 済 | 1刷 | 2018.05.07 | ||||||

| 190 リスト5-2-(10) 上から1行目 |

|

4刷 | 済 | 1刷 | 2018.05.07 | ||||||

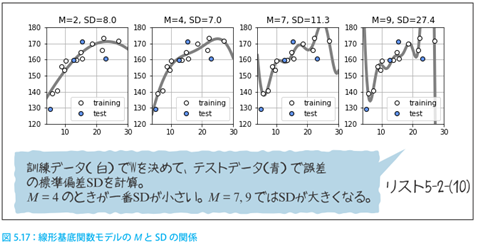

| 190 図5-17 |

|

4刷 | 済 | 1刷 | 2018.05.07 | ||||||

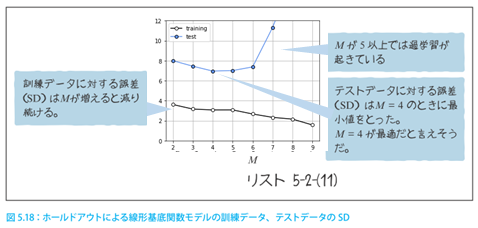

| 191 図5-18 |

|

4刷 | 済 | 1刷 | 2018.05.07 | ||||||

| 192 下から2行目 |

|

5刷 | 済 | 1刷 | 2018.07.12 | ||||||

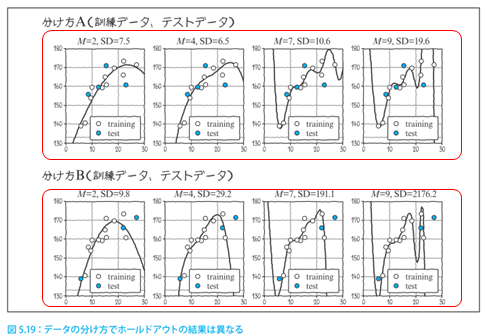

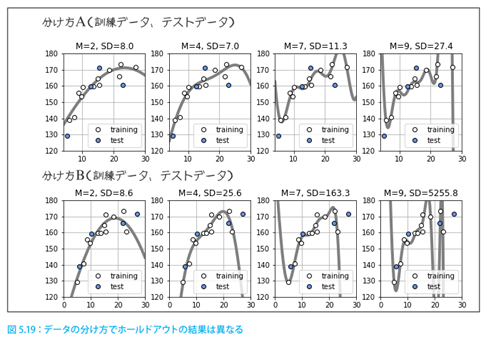

| 192 図5-19 |

|

4刷 | 済 | 1刷 | 2018.05.07 | ||||||

| 193 図5.20 キャプション |

|

5刷 | 済 | 1刷 | 2018.07.12 | ||||||

| 195 上から本文2行目 |

|

5刷 | 済 | 1刷 | 2018.07.12 | ||||||

| 196 図5.21 右下の吹き出し |

|

2刷 | 済 | 1刷 | 2018.02.02 | ||||||

| 202 下から4行目 |

|

4刷 | 済 | 1刷 | 2018.05.29 | ||||||

| 202 リスト 5-2-(20) 上から6行目と14行目、本文:下から7行目 |

|

3刷 | 済 | 1刷 | 2018.02.13 | ||||||

| 203 図5.25、本文:下から3行目 |

|

3刷 | 済 | 1刷 | 2018.02.13 | ||||||

| 208 図6.1 右下 |

|

5刷 | 済 | 1刷 | 2018.11.02 | ||||||

| 208 上から2-3行目 |

|

3刷 | 済 | 1刷 | 2018.02.13 | ||||||

| 215 上から3行目 |

|

2刷 | 済 | 1刷 | 2018.02.02 | ||||||

| 216 図6.6 グモイド曲線の位置(真ん中と下) |

|

4刷 | 済 | 1刷 | 2018.05.21 | ||||||

| 222 下から4行目 |

|

3刷 | 済 | 1刷 | 2018.02.23 | ||||||

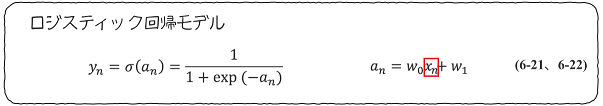

| 226 図6.8 「ロジスティック回帰モデル」の式で x の添え字が不足 |

|

3刷 | 済 | 1刷 | 2018.02.13 | ||||||

| 234 リスト 6-2-(7) 下から6行目 |

|

3刷 | 済 | 1刷 | 2018.02.13 | ||||||

| 235 下から4行目、下から1行目 |

|

3刷 | 済 | 1刷 | 2018.02.27 | ||||||

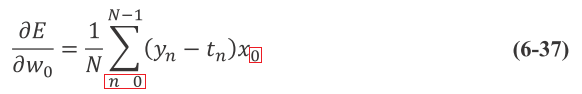

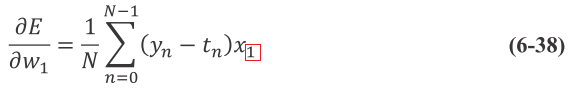

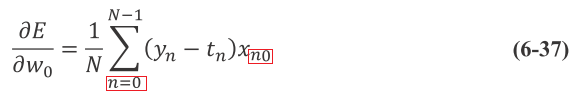

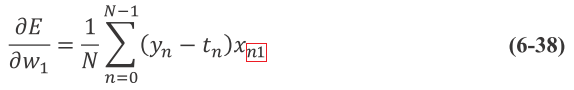

| 236 式6-37、式6-38、リスト 6-2-(9)の2行目コメント、6-2-(10)の2行目コメント |

|

3刷 | 済 | 1刷 | 2018.02.23 | ||||||

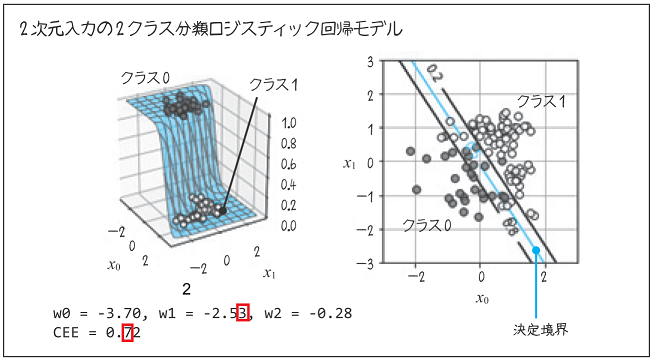

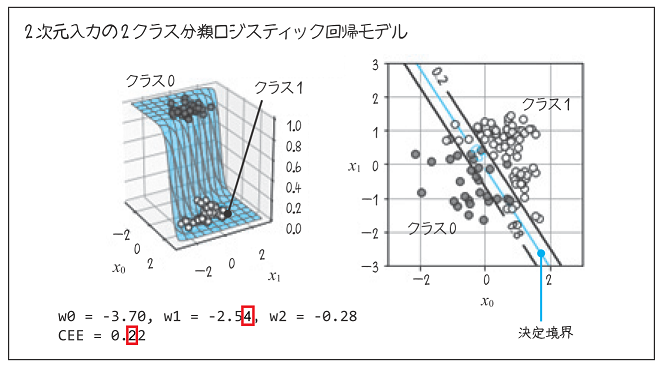

| 238 図6.12内の値の修正 |

|

3刷 | 済 | 1刷 | 2018.02.13 | ||||||

| 240 式6-44 |

|

4刷 | 済 | 1刷 | 2018.05.10 | ||||||

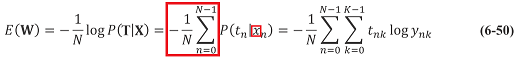

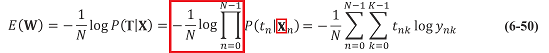

| 242 式6-50 |

|

3刷 | 済 | 1刷 | 2018.02.06 | ||||||

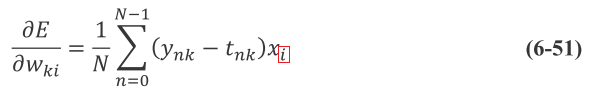

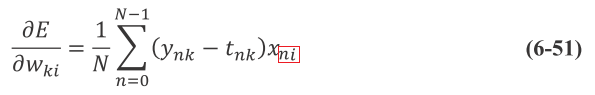

| 243 式6-51 |

|

3刷 | 済 | 1刷 | 2018.02.23 | ||||||

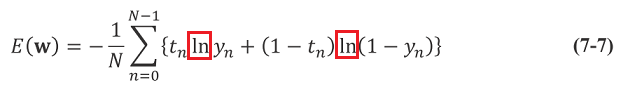

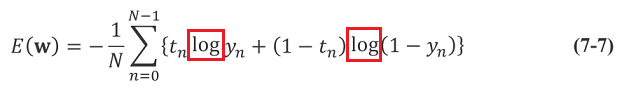

| 255 式7-7 ln を logに修正 |

|

3刷 | 済 | 1刷 | 2018.02.14 | ||||||

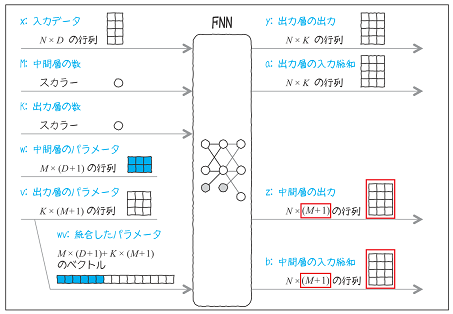

| 257 図7.6 右上の枠内 |

|

3刷 | 済 | 1刷 | 2018.02.06 | ||||||

| 263 図7.8 |

|

3刷 | 済 | 1刷 | 2018.02.13 | ||||||

| 264 リスト 7-1-(4) の下から6行目のコメント |

|

3刷 | 済 | 1刷 | 2018.02.13 | ||||||

| 266 リスト7-1-(5)の上から2行目のコメント、下から3行目 |

|

3刷 | 済 | 1刷 | 2018.02.13 | ||||||

| 271 該当ページのリスト 7-1-(7)の1行目 epsilon = 0.001 の削除 |

|

3刷 | 済 | 1刷 | 2018.02.13 | ||||||

| 274 リスト 7-1-(10) 中 15行目 |

|

5刷 | 済 | 1刷 | 2018.09.14 | ||||||

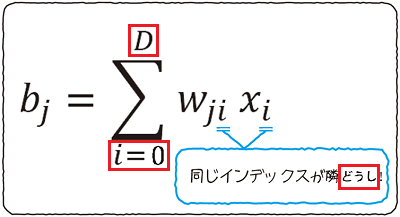

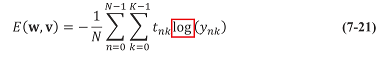

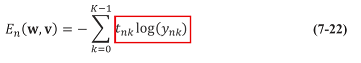

| 276 式7-21、式7-22、下から10行目、下から5行目 |

|

3刷 | 済 | 1刷 | 2018.02.13 | ||||||

| 277 数式を除いて、4行目 |

|

5刷 | 済 | 1刷 | 2018.09.14 | ||||||

| 277 上から4行目、5行目 |

|

3刷 | 済 | 1刷 | 2018.02.19 | ||||||

| 279 下から2行目 |

|

5刷 | 済 | 1刷 | 2018.11.02 | ||||||

| 279 下から8行目、下から2行目 |

|

3刷 | 済 | 1刷 | 2018.02.13 | ||||||

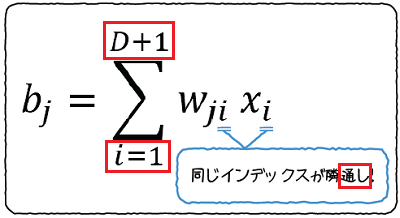

| 281 図7.14 左下、入力層の四角の中の xj は xi |

|

3刷 | 済 | 1刷 | 2018.02.19 | ||||||

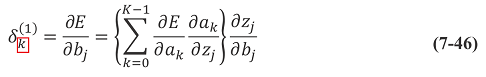

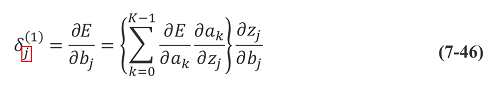

| 283 式7-46、下から1行目、図7.15 |

|

3刷 | 済 | 1刷 | 2018.02.13 | ||||||

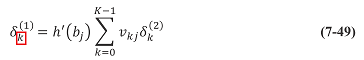

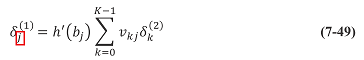

| 284 式7-49 |

|

3刷 | 済 | 1刷 | 2018.02.13 | ||||||

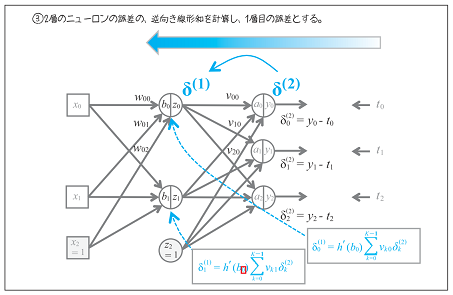

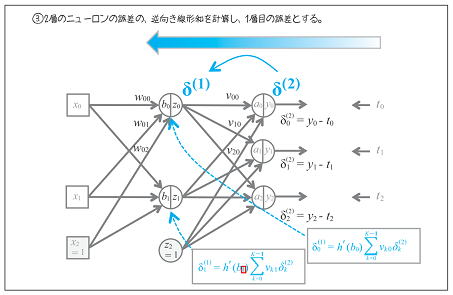

| 286 図7-19 δ1(1) の式内のh'() 関数の引数 b の添え字 |

|

3刷 | 済 | 1刷 | 2018.02.13 | ||||||

| 289 上から11行目 |

|

5刷 | 済 | 1刷 | 2018.11.27 | ||||||

| 290 図7.22 左図タイトル |

|

未 | 未 | 1刷 | 2020.02.14 | ||||||

| 291 リスト7-1-(12)の下から5行目 |

|

5刷 | 済 | 1刷 | 2018.11.27 | ||||||

| 291 リスト7-1-(12)の上から8行目の epsilon = 0.001 の削除 |

|

3刷 | 済 | 1刷 | 2018.02.13 | ||||||

| 293 下から3~4行目 |

|

3刷 | 済 | 1刷 | 2018.02.27 | ||||||

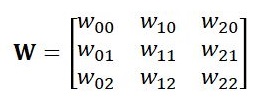

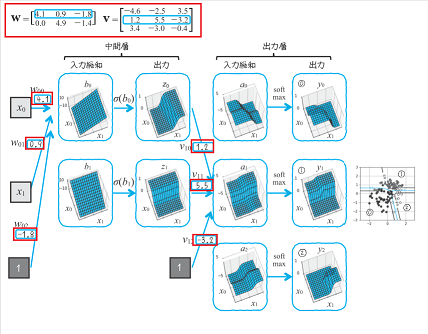

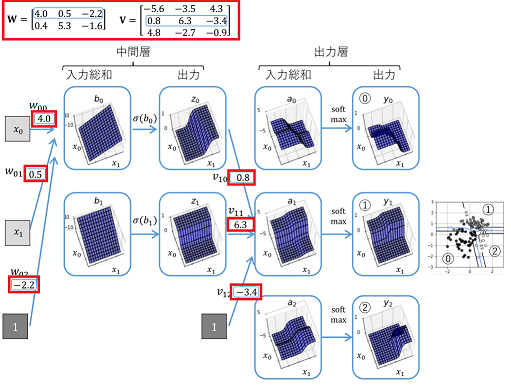

| 297 図 7.25 W, V の値 |

|

3刷 | 済 | 1刷 | 2018.02.13 | ||||||

| 297 上から4行目、上から5行目 |

|

3刷 | 済 | 1刷 | 2018.02.14 | ||||||

| 300 リスト7-2-(3) の12行目 |

|

3刷 | 済 | 1刷 | 2018.02.13 | ||||||

| 303 下から1行目 |

|

3刷 | 済 | 1刷 | 2018.02.27 | ||||||

| 305 2行目~3行目 |

|

未 | 未 | 1刷 | 2019.01.22 | ||||||

| 306 図 7.26の(A)と(B) |

|

5刷 | 済 | 1刷 | 2018.11.27 | ||||||

| 313 上から2行目 |

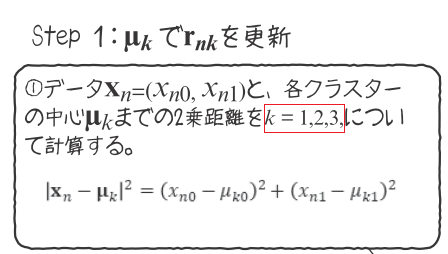

|

3刷 | 済 | 1刷 | 2018.02.27 | ||||||

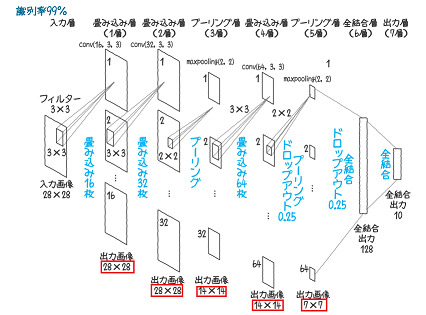

| 315 図8.4 |

|

3刷 | 済 | 1刷 | 2018.02.27 | ||||||

| 321 上から2行目 |

|

5刷 | 済 | 1刷 | 2018.11.27 | ||||||

| 324 本文上から2行目 |

|

3刷 | 済 | 1刷 | 2018.03.02 | ||||||

| 333 上から1行目 |

|

3刷 | 済 | 1刷 | 2018.02.14 | ||||||

| 336 下から5行目 |

|

4刷 | 済 | 1刷 | 2018.02.14 | ||||||

| 337 上から1行目、上から4行目 |

|

3刷 | 済 | 1刷 | 2018.02.14 | ||||||

| 346 上から5行目 |

|

3刷 | 済 | 1刷 | 2018.02.16 | ||||||

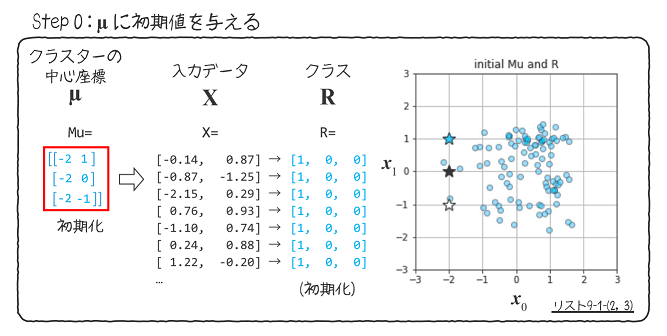

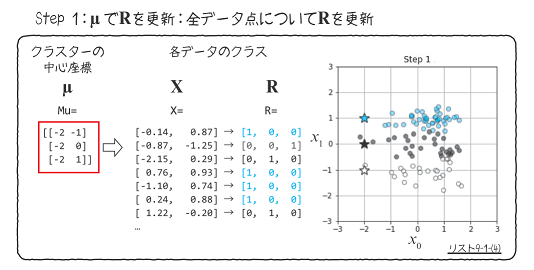

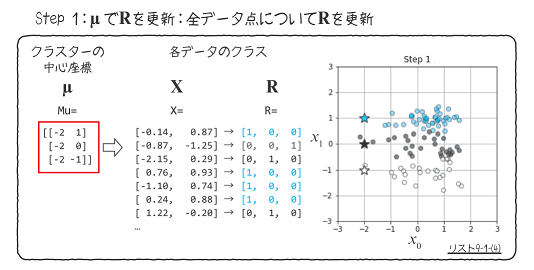

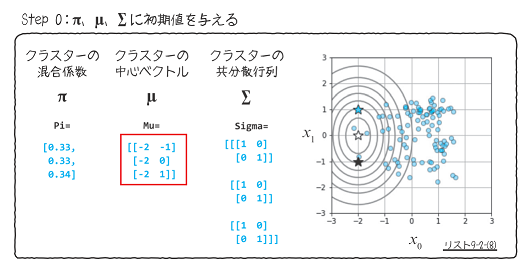

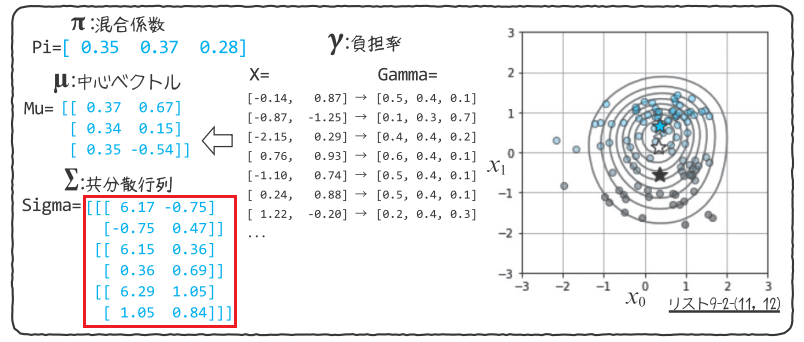

| 348 図9.3 Mu = の下の値 |

|

3刷 | 済 | 1刷 | 2018.02.16 | ||||||

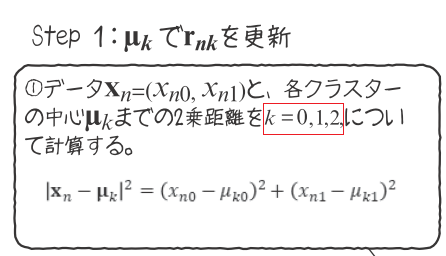

| 349 図9.4 Step1 |

|

3刷 | 済 | 1刷 | 2018.02.16 | ||||||

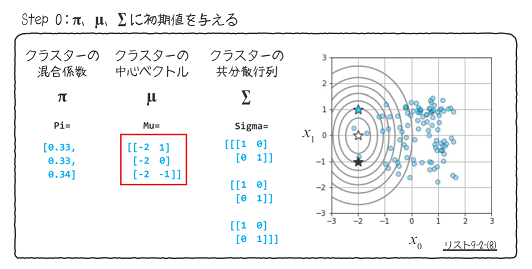

| 351 図9.5 Mu = の下の値 |

|

3刷 | 済 | 1刷 | 2018.02.16 | ||||||

| 360 上から1行目 |

|

5刷 | 済 | 1刷 | 2018.11.27 | ||||||

| 362 上から9行目 プログラムコード |

|

未 | 未 | 1刷 | 2020.02.14 | ||||||

| 367 上から7行目 |

|

3刷 | 済 | 1刷 | 2018.03.02 | ||||||

| 368 図9.13 |

|

3刷 | 済 | 1刷 | 2018.02.16 | ||||||

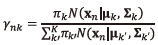

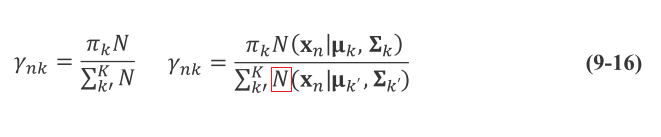

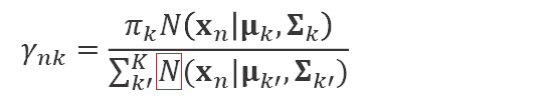

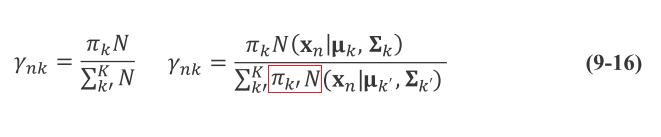

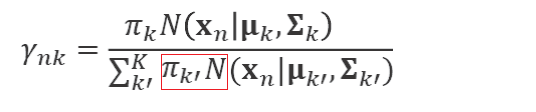

| 369 式9-16 |

|

5刷 | 済 | 1刷 | 2018.11.27 | ||||||

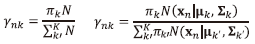

| 369 式9-16、図9.14 |

|

3刷 | 済 | 1刷 | 2018.03.02 | ||||||

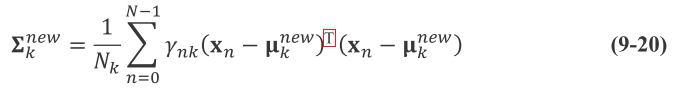

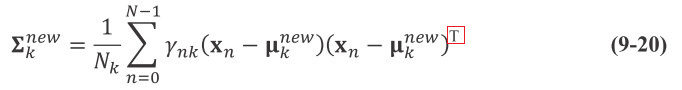

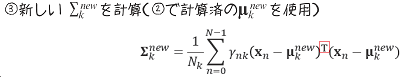

| 371 式9-20 |

|

3刷 | 済 | 1刷 | 2018.03.02 | ||||||

| 373 図9.15 |

|

3刷 | 済 | 1刷 | 2018.02.16 | ||||||

| 378 リスト 9-2-(15)の 9行目のコメント |

|

3刷 | 済 | 1刷 | 2018.02.16 |

MATSUDA, Shougo さん

2019-06-15

同シリーズ読み進めてますが、本書も学び多し。本書と同シリーズのKeras/Tensorflow本で結構実践的に学べます。

ogappy さん

2018-12-09

とある講座の教科書として。jupyter notebookをつかっているのと先生つきでしたのでサクサクと。 数学のまとめは不要かなぁ。

funa1g さん

2021-03-10

基本的な数学から押さえつつ、機械学習に関して数学的に理解する本。まさに教科書。大学学部レベルの人工知能の授業っぽい。出てくる数学の解説もありますが、これだけで理解するのはしんどいと思うので、できたら大学数学か最低でも高校数学くらいの基礎はほしい。なんとなく機械学習ライブラリが動かせる、みたいな感じではなく、論文も読み下せるようになりたい人の入門書として有用。少なくともこれくらいは読み下せないとPRMLは読めないので、有名だからとPRMLとかに行く前にオススメ。

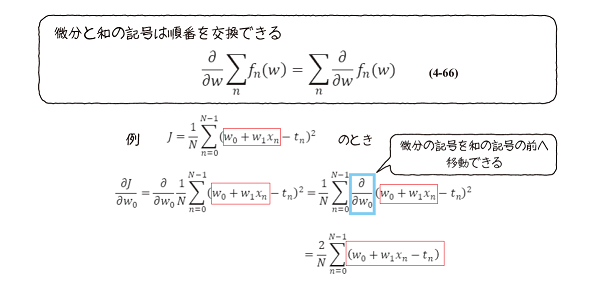

・図4.15(図内の数式)

・図4.15(図内の数式)

・図4.15キャプション

図 4-15 偏微分の連鎖律

・上から5行目

微分の記号を和の前に

・図4.15キャプション

図 4-15 偏微分の連鎖律

・上から5行目

微分の記号を和の前に

・図4.15(図内の数式)

・図4.15(図内の数式)

・図4.15キャプション

図 4-15 微分と和の記号の交換

・上から5行目

微分の記号を和の記号の前に

・図4.15キャプション

図 4-15 微分と和の記号の交換

・上から5行目

微分の記号を和の記号の前に

・式5-24

・式5-24

・式5-24

・式5-24

・グラフ下の説明:下から3行目

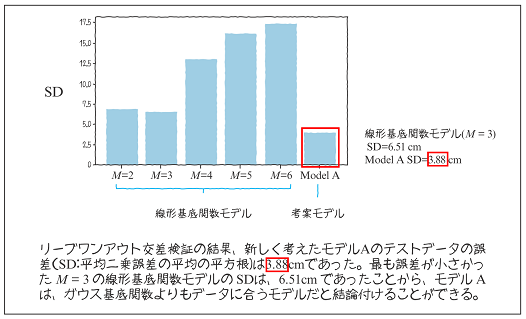

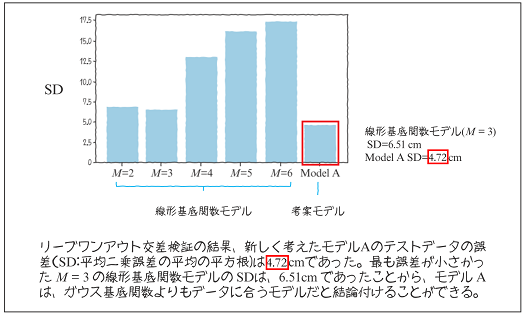

誤:3.88 cm であった。

・グラフ下の説明:下から3行目

誤:3.88 cm であった。 ・グラフ下の説明:下から3行目

正:4.72 cm であった。

・グラフ下の説明:下から3行目

正:4.72 cm であった。

・リスト 6-2-(9)の2行目コメント

クロスエントロピー誤差

・リスト 6-2-(10)の2行目コメント

クロスエントロピー誤差 の微分

・リスト 6-2-(9)の2行目コメント

クロスエントロピー誤差

・リスト 6-2-(10)の2行目コメント

クロスエントロピー誤差 の微分

・リスト 6-2-(9)の2行目コメント

交差エントロピー誤差

・リスト 6-2-(10)の2行目コメント

交差エントロピー誤差 の微分

・リスト 6-2-(9)の2行目コメント

交差エントロピー誤差

・リスト 6-2-(10)の2行目コメント

交差エントロピー誤差 の微分

・式7-22

・式7-22

・下から10行目

相互エントロピー誤差

・下から5行目

平均相互エントロピー誤差は、データ個別の相互エントロピー誤差の

・下から10行目

相互エントロピー誤差

・下から5行目

平均相互エントロピー誤差は、データ個別の相互エントロピー誤差の

・式7-22

・式7-22

・下から10行目

交差エントロピー誤差

・下から5行目

平均交差エントロピー誤差は、データ個別の交差エントロピー誤差の

・下から10行目

交差エントロピー誤差

・下から5行目

平均交差エントロピー誤差は、データ個別の交差エントロピー誤差の ・下から1行目

よって、式7-48 は、次の式7-49 となります。

・図7.15(aの部分)

Wji(t+1) = Wji(t) - a δj(1) Xi の意味

・下から1行目

よって、式7-48 は、次の式7-49 となります。

・図7.15(aの部分)

Wji(t+1) = Wji(t) - a δj(1) Xi の意味

・下から1行目

よって、式7-46 は、次の式7-49 となります。

・図7.15(aをαに修正)

Wji(t+1) = Wji(t) - α δj(1) Xi の意味

・下から1行目

よって、式7-46 は、次の式7-49 となります。

・図7.15(aをαに修正)

Wji(t+1) = Wji(t) - α δj(1) Xi の意味

・上から1行目

半分の 14 × 14

・上から4行目

画像サイズが 7 × 7

・上から1行目

半分の 14 × 14

・上から4行目

画像サイズが 7 × 7

・上から1行目

半分の 12 x 12

・上から4行目

画像サイズが 5 x 5

・上から1行目

半分の 12 x 12

・上から4行目

画像サイズが 5 x 5

・図9.14

・図9.14

・図9.14

・図9.14

・図9.15下

・図9.15下

・図9.15下

・図9.15下

.png)