最強囲碁AI アルファ碁 解体新書 深層学習、モンテカルロ木探索、強化学習から見たその仕組み

- 形式:

- 書籍

- 発売日:

- 2017年07月19日

- ISBN:

- 9784798152561

- 定価:

- 2,860円(本体2,600円+税10%)

- 仕様:

- A5・272ページ

- カテゴリ:

- 人工知能・機械学習

- キーワード:

- #プログラミング,#開発手法,#データ・データベース,#ビジネスIT

「神の一手」の謎にせまる!

【概要】

2017年5月にアルファ碁(AlphaGo)と柯潔(カ・ケツ)九段の最終決戦が行われ、

アルファ碁の3連勝となりました。アルファ碁は今回の対戦で

さらに進化をとげました。

このようにAIの技術進化は日進月歩で進んでおり、国内でも

企業や研究開発が進んています。中でも注目されているのは、

機械学習・深層学習・強化学習です。

本書はネイチャー誌で提供されているアルファ碁に関する

難解な学術論文を著者のほうで読み解き、アルファ碁で

利用されている深層学習や強化学習、モンテカルロ木探索の

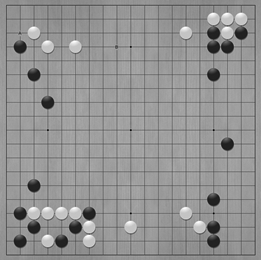

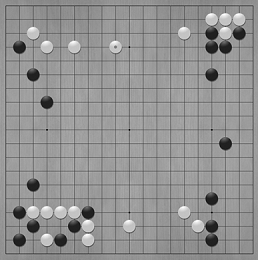

仕組みについて、実際の囲碁の画面も参照しながら、

わかりやすく解説した書籍です。

本書を読むことで、最新のAIに深層学習、強化学習、

モンテカルロ木探索がどのように利用されているかを

知ることができ、実際の研究開発の参考にすることができます。

【読者対象】

・人工知能関連の開発に携わる開発者、研究者

・ゲームAI開発者

【著者】

大槻 知史(おおつき・ともし)

2001年東京大学工学部計数工学科卒業。2003年同大学院新領域創成科学研究科複雑理工学専攻修士課程修了。

以降、機械学習・最適化などの研究開発に取り組む。

ゲームAIプログラマーとしては、2001年より、囲碁・将棋プログラムの開発に従事。

著者の開発した将棋プログラム「大槻将棋」は、2009年世界コンピュータ将棋選手権にて第2位。博士(情報理工学)。

【監修者】

三宅 陽一郎(みやけ・よういちろう)

デジタルゲームの人工知能の開発者。京都大学で数学を専攻、大阪大学大学院物理学修士課程、

東京大学大学院工学系研究科博士課程を経て、人工知能研究の道へ。

ゲームAI開発者としてデジタルゲームにおける人工知能技術の発展に従事。

国際ゲーム開発者協会日本ゲームAI専門部会設立(チェア)、日本デジタルゲーム学会理事、芸術科学会理事、人工知能学会編集委員。

共著『デジタルゲームの教科書』『デジタルゲームの技術』『絵でわかる人工知能』(SBCr) 、

著書『人工知能のための哲学塾』(BNN新社)、『人工知能の作り方』(技術評論社)、

『ゲーム、人工知能、環世界』(現代思想、青土社、2015/12)、最新の論文は

『デジタルゲームにおける人工知能技術の応用の現在』(人工知能学会誌 2015年、学会Webにて公開)。

Chapter2 ディープラーニング ~囲碁AIは瞬時にひらめく~

Chapter3 強化学習 ~囲碁AIは経験に学ぶ~

Chapter4 探索 ~囲碁AIはいかにして先読みするか~

Chapter5 アルファ碁の完成

Appendix1 数式について

Appendix2 囲碁プログラム用のUIソフト「GoGui」およびGoGui用プログラム「DeltaGo」の利用方法

付属データはこちら

書籍の購入や、商用利用・教育利用を検討されている法人のお客様はこちら

図書館での貸し出しに関するお問い合わせはよくあるお問い合わせをご確認ください。

利用許諾に関するお問い合わせ

本書の書影(表紙画像)をご利用になりたい場合は書影許諾申請フォームから申請をお願いいたします。

書影(表紙画像)以外のご利用については、こちらからお問い合わせください。

お問い合わせ

内容についてのお問い合わせは、正誤表、追加情報をご確認後に、お送りいただくようお願いいたします。

正誤表、追加情報に掲載されていない書籍内容へのお問い合わせや

その他書籍に関するお問い合わせは、書籍のお問い合わせフォームからお送りください。

現在表示されている正誤表の対象書籍

書籍の種類:紙書籍

書籍の刷数:全刷

書籍によっては表記が異なる場合がございます

本書に誤りまたは不十分な記述がありました。下記のとおり訂正し、お詫び申し上げます。

対象の書籍は正誤表がありません。

| ページ数 | 内容 | 書籍修正刷 | 電子書籍訂正 | 発生刷 | 登録日 | ||||||

|---|---|---|---|---|---|---|---|---|---|---|---|

| 006 下から9行目 |

|

2刷 | 済 | 1刷 | 2017.08.08 | ||||||

| 068 図2.9の一番上の記述 |

|

2刷 | 済 | 1刷 | 2017.08.08 | ||||||

| 073 2.2.6の見出し |

|

2刷 | 済 | 1刷 | 2017.08.08 | ||||||

| 087 下から2行目 |

|

2刷 | 済 | 1刷 | 2017.08.08 | ||||||

| 088 図2.18(a) |

|

2刷 | 済 | 1刷 | 2017.08.08 | ||||||

| 105 上から8行目 |

|

2刷 | 済 | 1刷 | 2017.08.08 | ||||||

| 106 下から5行目 |

|

2刷 | 済 | 1刷 | 2017.08.08 | ||||||

| 107 MEMOの中、上から2行目 |

|

2刷 | 済 | 1刷 | 2017.08.08 | ||||||

| 108 図2.25のキャプション |

|

2刷 | 済 | 1刷 | 2017.08.08 | ||||||

| 133 図3.4 (b)UCB1が大きい腕を選ぶ方策の場合 |

|

未 | 済 | 1刷 | 2018.02.14 | ||||||

| 139 上から5行目 |

|

2刷 | 済 | 1刷 | 2017.08.08 | ||||||

| 141 MEMO ステップ数の中 |

|

2刷 | 済 | 1刷 | 2017.08.08 | ||||||

| 143 上から7〜8行目 |

|

2刷 | 済 | 1刷 | 2017.08.08 | ||||||

| 152 表3.1のATARI×エピソードのセル |

|

2刷 | 済 | 1刷 | 2017.08.08 | ||||||

| 153 Step 4の見出し |

|

2刷 | 済 | 1刷 | 2017.08.08 | ||||||

| 159 上から1〜2行目 |

|

2刷 | 済 | 1刷 | 2017.08.08 | ||||||

| 160 図3.16フローチャートの一番上の□の中 |

|

2刷 | 済 | 1刷 | 2017.08.08 | ||||||

| 229 図5.10の横軸の文字列 |

|

未 | 済 | 2刷 | 2017.08.08 | ||||||

| 262 下から2行目 |

|

2刷 | 済 | 1刷 | 2017.08.08 | ||||||

| 264 INDEXの「Compute Unifi ed Device Architecture」 |

|

2刷 | 済 | 1刷 | 2017.08.08 |

suoyimi さん

2018-09-26

ネイチャーに投稿されたアルファ碁の論文を元にアルファ碁で採用している手法を紹介しています。これらの論文は普通に読むと全体像が理解しにくいですが、本書を読むことで全体像を理解しながらアルファ碁の理解を進めることができます。 ディープラーニング、強化学習、探索の3つの領域に分けて、過去からの進歩の様子をわかりやすく説明しています。数式はほとんどでてこないので理系以外の方が読んでも面白いと思います。

wellon さん

2018-08-14

「人工知能」といった時に裏側で何が行われているのかを、囲碁AIを題材に扱った名著。 古典的なモンテカルロ木、自己対戦の繰り返しによる強化学習、プロの棋譜を基に学習するディープラーニングなどなど。 人工知能に興味がある人が3冊目くらいに読むと大変勉強になる本です。(1冊目にするとハードです。)

Ursula さん

2018-08-06

分かりやすい解説。論文自体も読まなきゃなあ

.png)